近日,科大讯飞研究院与认知智能全国重点实验室联合研究团队在Nature 旗下国际重要期刊《通讯-化学》(Communications Chemistry)发表题为《Evaluating Large Language Models on Multimodal Chemistry Olympiad Exams》的研究论文,展示了大模型在科学推理与化学智能理解方向上的新进展。

论文标题:

Evaluating large language models on multimodal chemistry olympiad exams

论文地址:

https://www.nature.com/articles/s42004-025-01782-x

让AI理解“图中的化学”

在化学研究中,图表、分子结构式、反应机理示意图与实验装置等视觉信息与文字描述同样重要。相比自然图像识别,化学问题要求AI具备跨模态的符号理解与逻辑推演能力。然而,当前多模态大模型在面对科学图像时,仍存在图像反而会拉低正确率的情况,暴露出视觉与语言融合能力的根本性瓶颈。

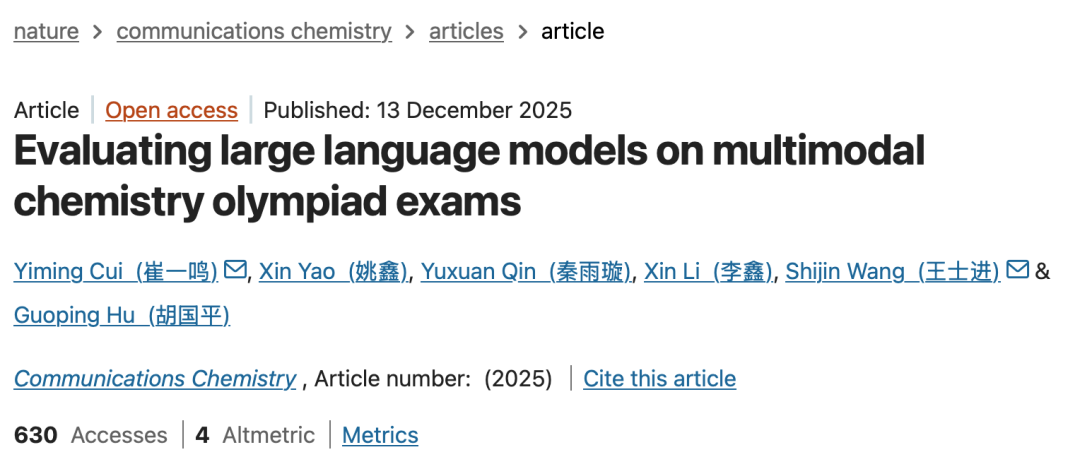

为此,研究团队系统性地构建了覆盖二十余年美国化学奥林匹克考试(USNCO)的多模态评测基准——USNCO-V。该基准包含473道图文结合的化学题目,涵盖分子结构、实验装置、反应曲线、表格与数据图等多种视觉类型,系统考察大模型在科学视觉理解与逻辑推理一体化方面的真实能力。

该研究首次以大规模、系统化的方式,评估了多模态大模型在化学推理任务中的整体表现,填补了AI for Science 领域在化学视觉推理系统性分析方向的关键空白。

除建立评测基准外,本论文更深入剖析了多模态大模型在科学推理中的内在机制,通过系统性对比与可解释性分析,成为未来科学推理型AI发展的“镜子”——能够精准揭示模型在视觉–语言融合、符号理解与跨模态逻辑推演方面的真实能力与潜在局限。

研究团队提出的化学多模态评测基准USNCO-V

首揭AI科学推理“视觉失配”现象

研究系统性评估了包括GPT-5、OpenAI o3、Gemini-2.5-Pro 等在内的40款主流多模态大语言模型,全面对比其在化学推理任务中的表现。结果显示,GPT-5以93.2%的宏平均准确率位居榜首,显著超越参赛选手平均成绩(44.6%),在化学奥赛级别任务中达到人类专家水平。

值得一提的是,部分模型在移除图像输入后反而表现更优,揭示了当前多模态融合中存在的“视觉干扰效应”,即模型在处理科学图像时未能实现真正的跨模态协同。

此外,研究发现思维链(Chain-of-Thought, CoT)提示能显著增强中等规模的大模型的推理能力,使GPT-4.1-mini在无需额外训练的情况下准确率提升超过26个百分点。而在任务类型上,当前大模型在表格与常规图表类题目中表现稳健,但在分子结构识别与实验装置理解方面仍存在明显短板。

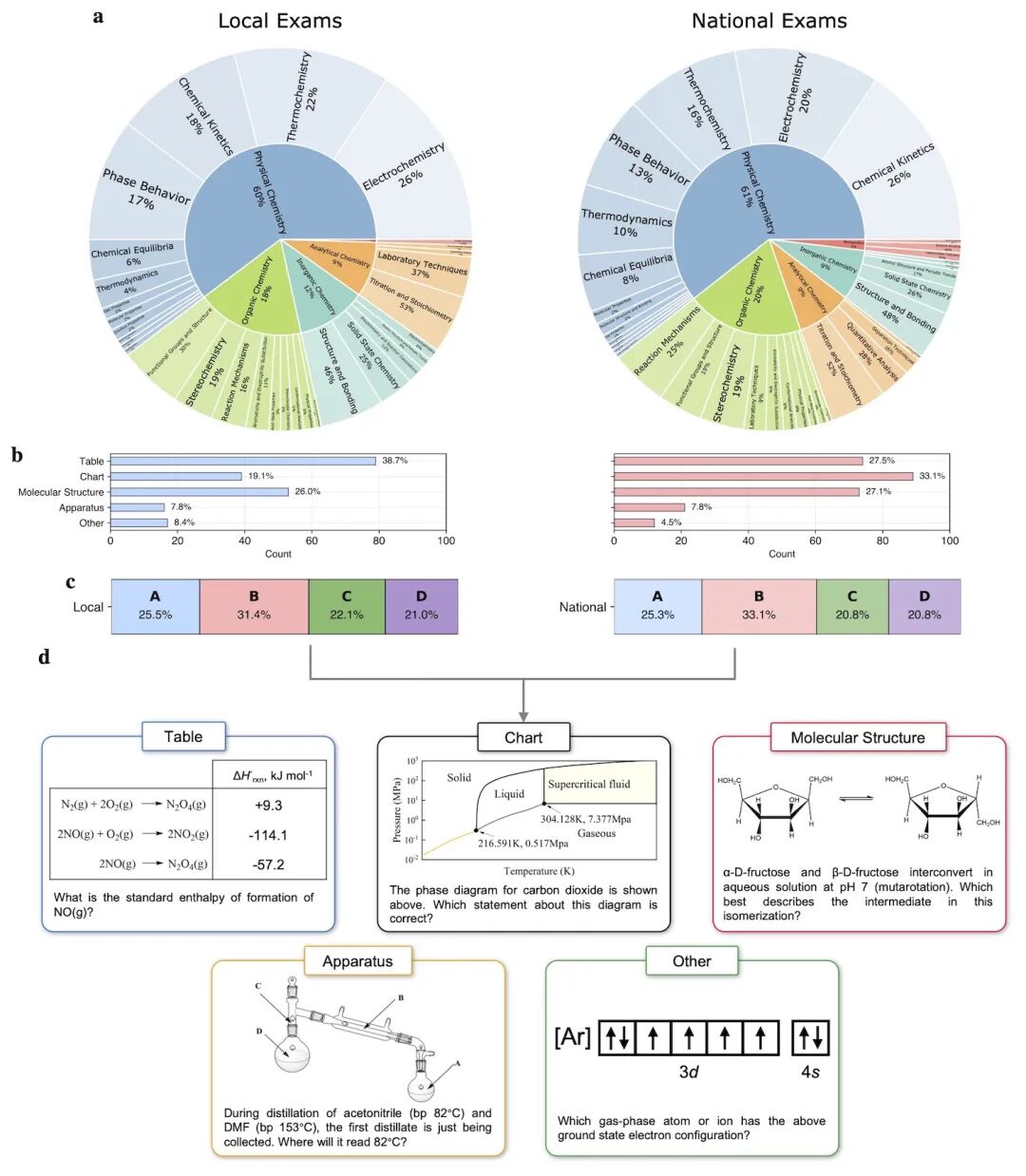

研究团队进一步通过遮挡敏感度分析(Occlusion-based Saliency)揭示了思维链提示如何引导模型从局部图像匹配转向整体比较推理,为多模态模型的可解释性研究提供了新的分析方法和途径。

面向化学多模态问答的遮挡式敏感度分析框架

科大讯飞持续布局AI for Science

此次发布的研究成果,目前已在科大讯飞主导参与的相关研究和项目中得到应用。例如今年5月发布的智能化工大模型2.0 Pro,在化工知识理解与反应预测等任务上取得领先成绩,并于11月5日升级推出3.0版本,进一步扩展了化工领域的多模态推理能力。

本次发表于Nature旗下《Communications Chemistry》的工作,是科大讯飞AI for Science研究团队在“科学视觉推理”方向上的重要延伸,从语言理解迈向科学理解,为AI驱动的科学发现开辟了新的范式。

科大讯飞在AI for Science领域持续深耕,已取得多项具有国际影响力的突破:

依托星火大模型底座,科大讯飞携手中国科学院共建“星火科研助手”平台,为全国1300余所高校的17万余名科研工作者提供智能文献分析与学术写作服务,累计功能调用近400万次;

在多学科融合研究方面,科大讯飞AI4S团队联合中科大、中科院等单位率先在《Nuclear Fusion》发布PaMMA-Net模型,突破等离子体磁测量演化建模瓶颈;

在化工方向,与中科院大连化物所合作推出智能化工大模型2.0 Pro,在《催化学报》上在线发表面向化工领域研发的700亿参数大模型ChenELLM;在化学方向,研制化学基础科学大模型,在化学分子理解任务上相较GPT-4o提升超过15%。

未来,科大讯飞将继续肩负大模型赋能科研的重要使命,深化AI与科学研究的融合创新,为AI for Science加速中国科技高质量发展贡献更大力量。